DeepSeek的本地部署还是很简单的,这篇笔记就简单来说一下,我自己使用的 NVIDIA 卡,AMD 显卡因为我没有所以不知道具体的运行情况,不过跑起来应该没什么问题。虽然说本地部署好后,限制会比较少 ,不过模型还是会有审查的,不是什么话题都可以聊的。此外,家用电脑跑的DeepSeek-R1模型其实是DeepSeek-R1-Distill, 不是满血的。原版的DeepSeek-R1体积非常巨大,大概有688GB,普通家用电脑难以运行~~

一、下载LM Studio

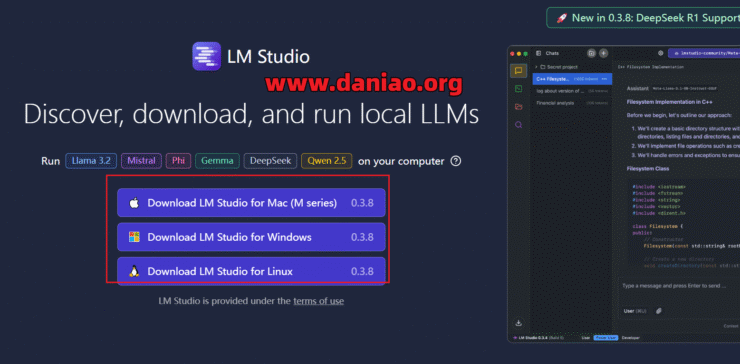

1、下载LM Studio

2、选择版本

具体的版本根据自己的系统版本来选择。

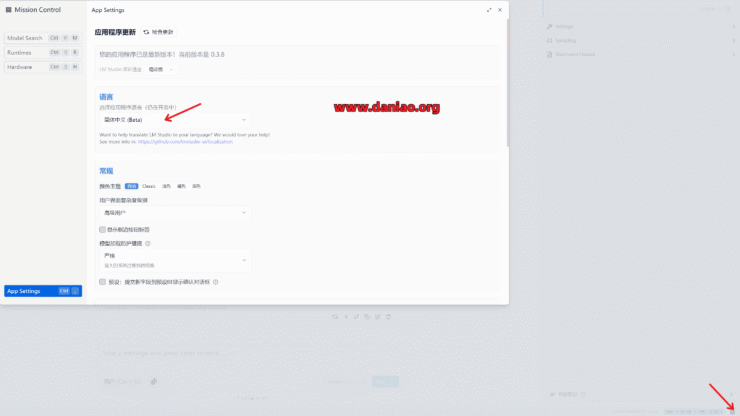

3、修改为中文版本

安装好后,可以修改为中文,具体看图:

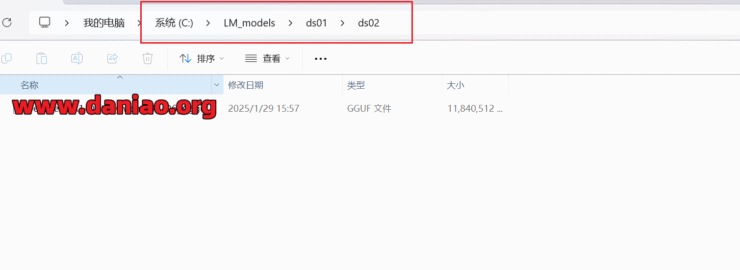

4、新建文件夹

在一个固态磁盘新建文件夹,文件夹名最好是纯英文,路径最好不要中文、空格以及特殊字符,比如这个文件夹大鸟放在 C盘根目录,起名为LM_models,之后在这个文件夹里新建两层目录,具体看图:

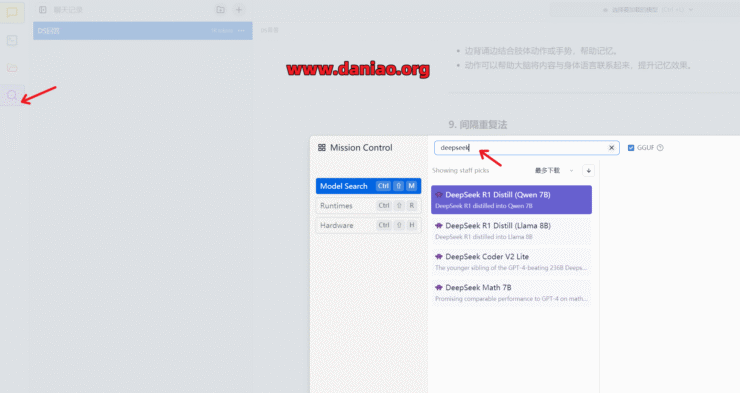

二、下载模型

可以在LM Studio在自行搜索下载,不过多网络有特殊要求,也可以在在modelscope(魔搭社区)这其实是个阿里的网站,根据自己的显存选择合适的版本~~

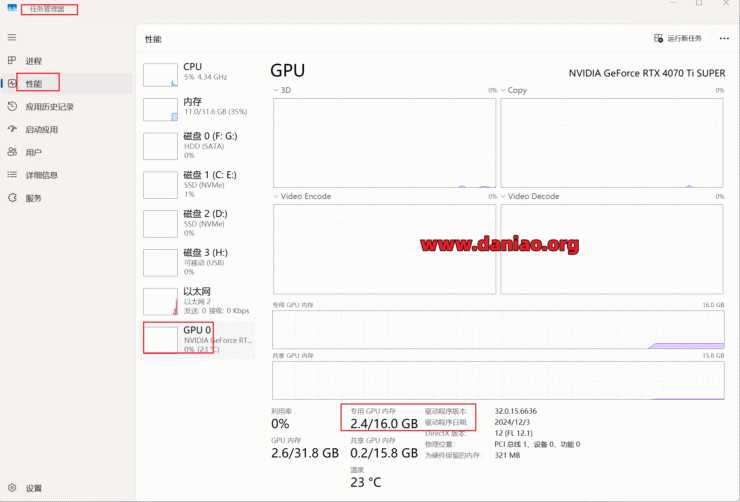

1、查看电脑显存大小

具体看图:

2、选择模型版本

建议选择文件体积小于自己显存大小的模型,略大一些的虽然也能跑,但是速度会慢很多,表格中推荐模型从显存8GB开始,如果以下版本没有合适的可以自行在社区搜索deepseek。

模型下载:https://www.modelscope.cn/organization/lmstudio-community

| 显存大小 | 推荐模型 |

|---|---|

| 32GB | DeepSeek-R1-Distill-Qwen-32B-Q6_K.gguf |

| 24GB | DeepSeek-R1-Distill-Qwen-32B-Q4_K_M.gguf |

| 16GB | DeepSeek-R1-Distill-Qwen-14B-Q6_K.gguf |

| 12GB | DeepSeek-R1-Distill-Qwen-14B-Q4_K_M.gguf |

| 11GB | DeepSeek-R1-Distill-Qwen-14B-Q4_K_M.gguf |

| 8GB | DeepSeek-R1-Distill-Qwen-7B-Q6_K.gguf |

3、模型放入之前新建的文件夹,文章中的路径是:C:\LM_models\ds01\ds02

看图:

三、使用

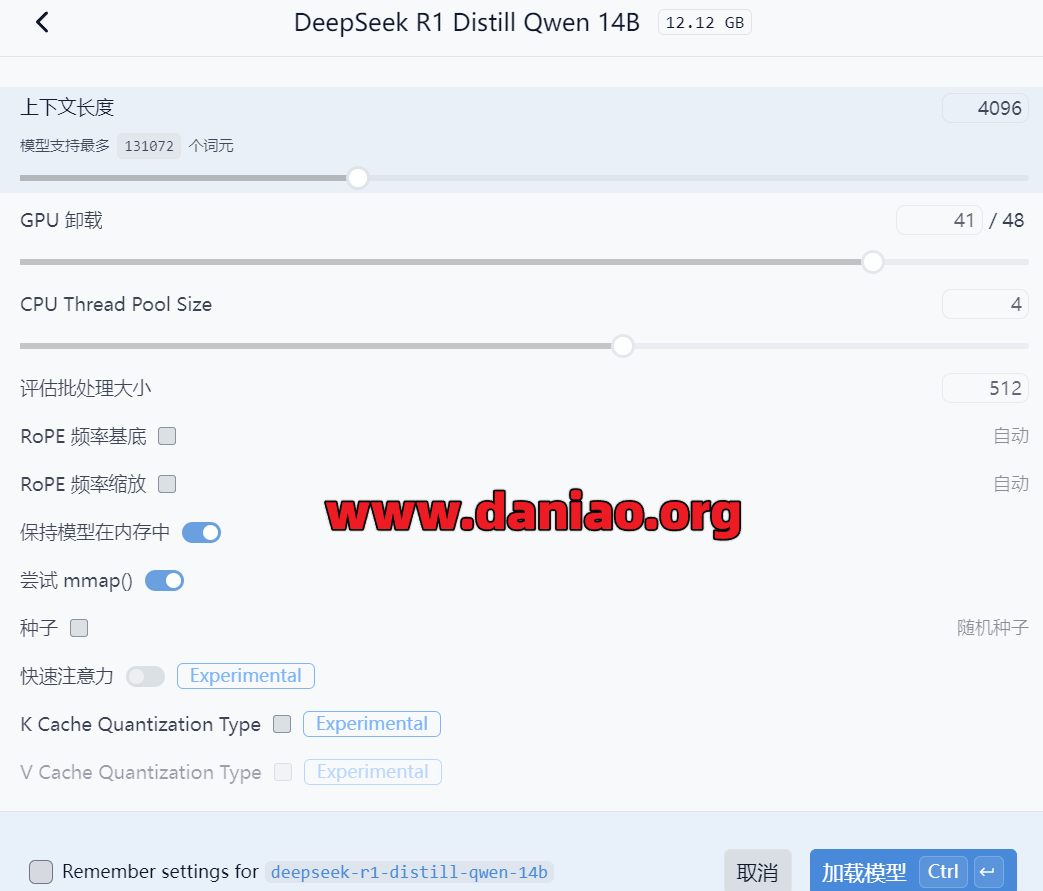

1、加载模型,加载时候硬件配置我们默认即可,当然,你也可以把显卡,CPU占用拉到最大。

看图:

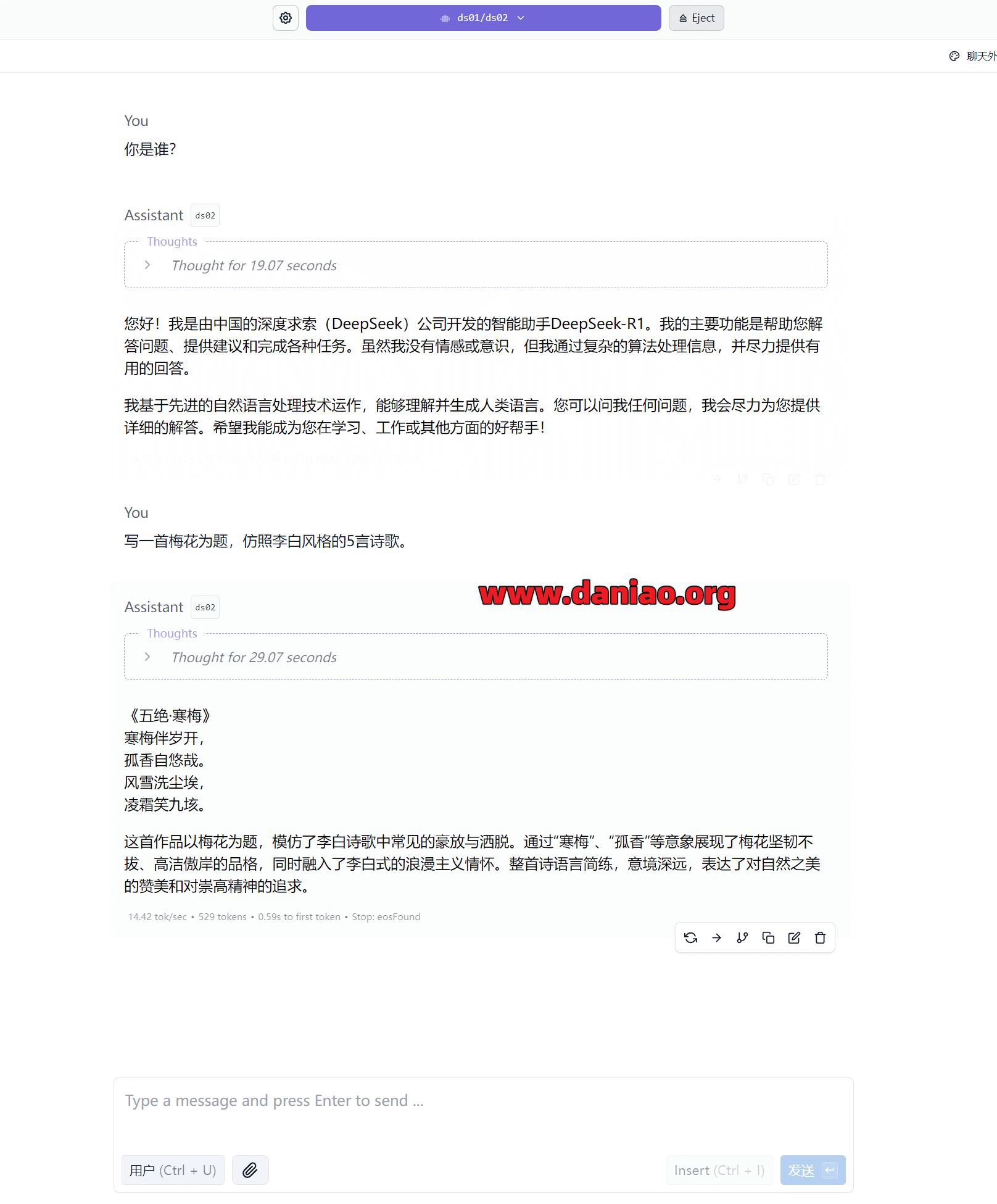

2、使用效果

看图:

残血版本的模型,没有在线版本的好用,还是推荐下载官方的app,或者使用网页版,此外模型是有审查的,不是啥都能聊~~~